Semi-supervised Semantic Segmentation via Strong-weak Dual-branch Network

Semi-supervised Semantic Segmentation via Strong-weak Dual-branch Network

# Semi-supervised Semantic Segmentation via Strong-weak Dual-branch Network

# 作者:中山大学 杨猛(ETH Zurich博士后)

# 发表:ECCV 2020 Spotlight

# 摘要

现有的工作探索了大量的技巧来推动弱监督语义分割,但就性能而言与全监督方法还有不小的差距。在真实应用中,除了大量的弱监督的图像,还存在少量可用的像素级的标注,基于这种标签的组成,半监督方法在语义分割任务中有前景。现有的方法简单地将两类标注融到一起训练一个分割网络,然后,我们发现这种处理方法存在问题,并且其性能甚至比只使用强监督标签的样本要差,这说明弱标签的潜力并未被完全挖掘。

为了能够完全挖掘出弱标签的潜能,我们提出了一个强-弱双分支网络来分别对待强标签和弱标签,从而将大量不准确的弱监督与强监督区分开来。我们设计了一个共享的网络组件利用对强弱标注的联合辨别。同时,所提出的双分支独立的处理全监督和弱监督学习,能够有效消除他们的彼此干扰。这种方法只需要较少的额外计算成本,却带来了显著的性能改进,在两个标准数据集上的实验展示了该方法的有效性。

# 阅读

# 论文的目的及结论

想利用双分支分别处理强弱标注的样本,两个分支独立地处理全监督和弱监督学习,能够有效消除他们彼此间的干扰,该方法只需要较少的额外计算成本,却带来了显著的性能改进。

# 论文的实验

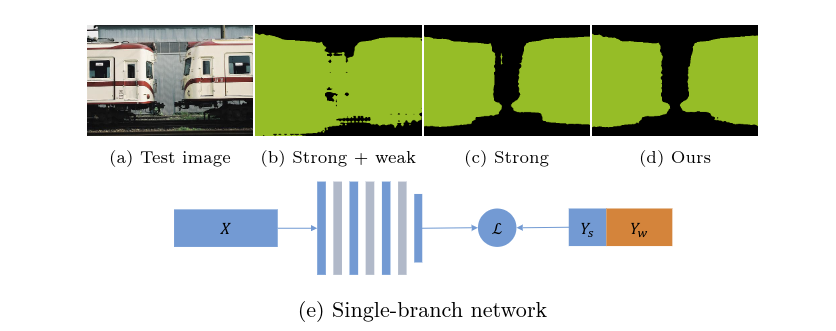

图一和图二是作者用来说明:如果弱标签使用不当是会损害模型性能的。

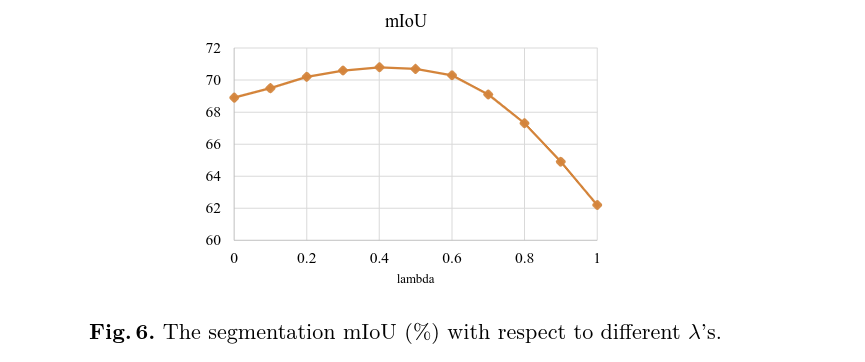

图六是作者针对 做的实验

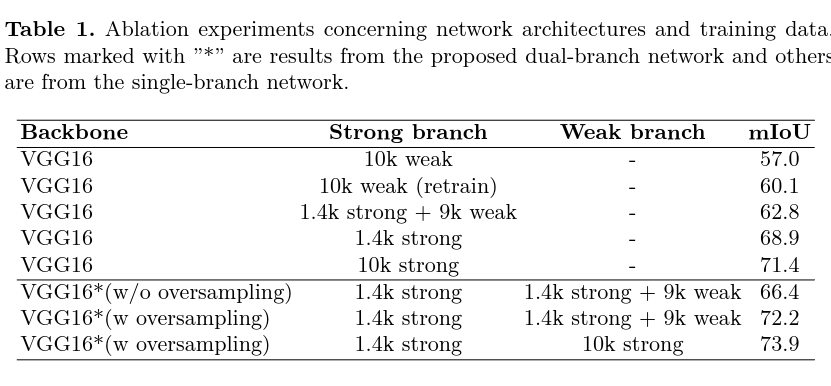

表一是VOC数据集上的消融实验,展现了双分支的有效性

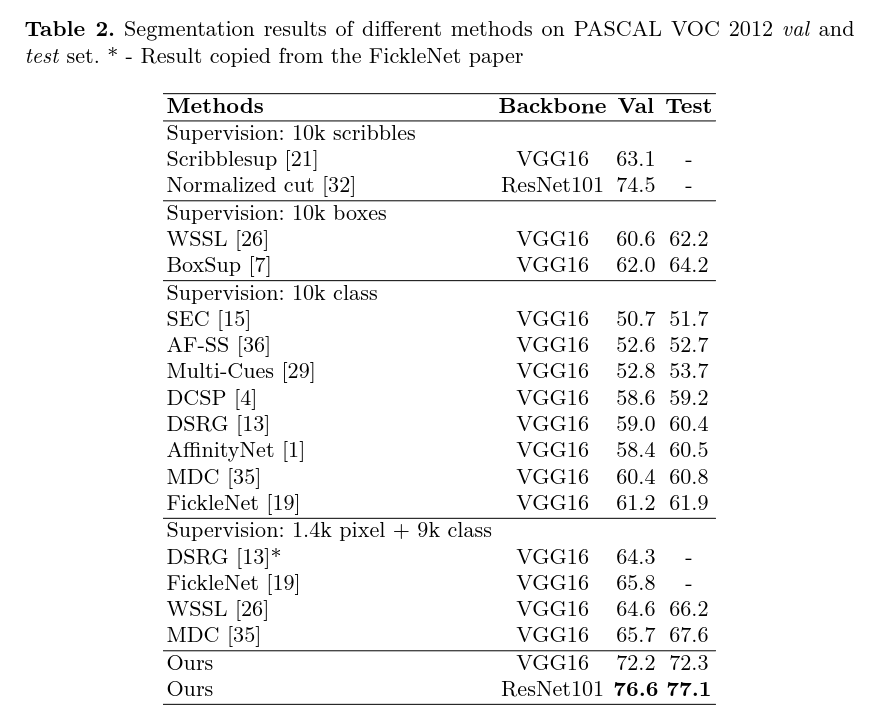

表二是和其他方法的对比,作者提出结果是从 FickleNet 论文中直接复制的。

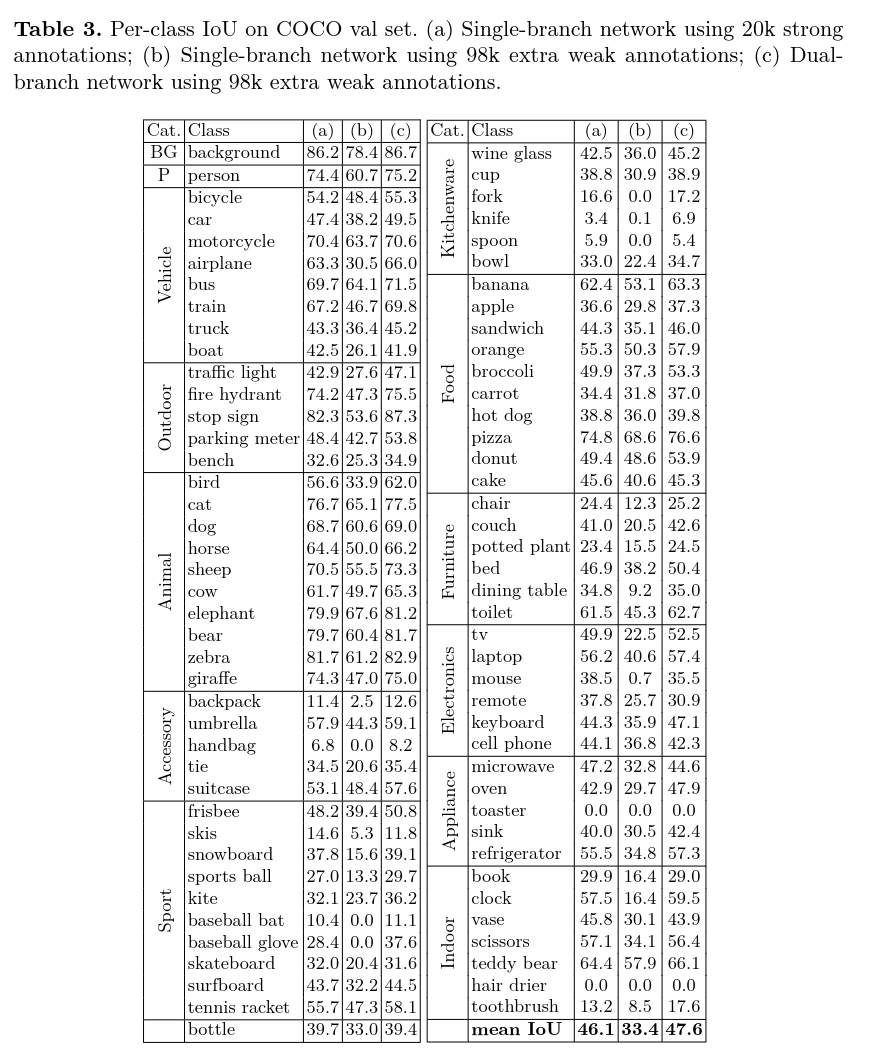

表三体现了在COCO val set 上每类的 IoU 结果,

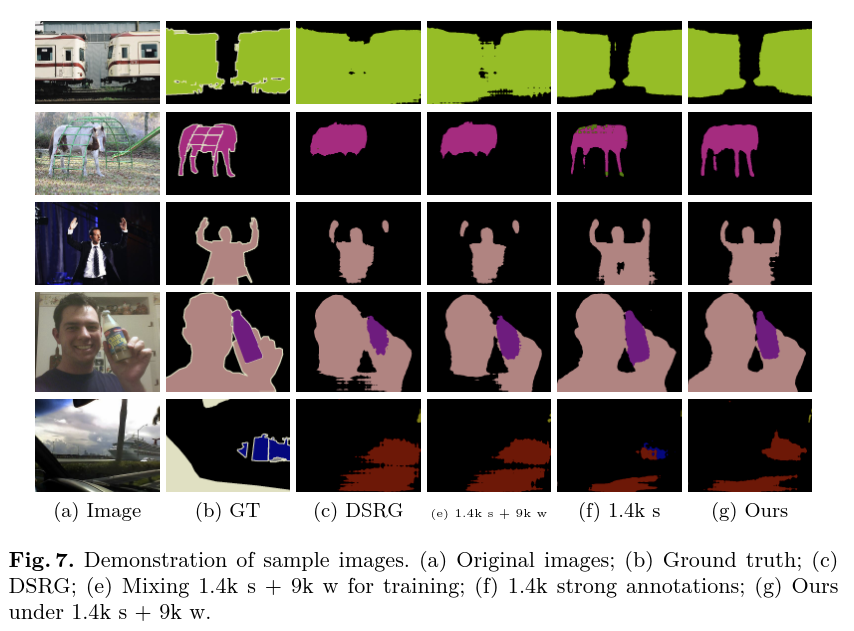

表七展示了图像样本,主要是和 DSRG 方法做对比。

# 论文的方法

弱监督方法估计出的代理监督信息相较于手工标记来说是质量较差的。对于精细标注和弱标注的语义分割任务来讲,一个方法是训两个不同的网络然后将输出取平均。这种做法不仅需要维护两个网络,而且单独的训练无法交换监督的信息。所以为了信息共享、消除样本不平衡以及监督信号不一致,提出了双分支网络来处理不同类型的监督信号。

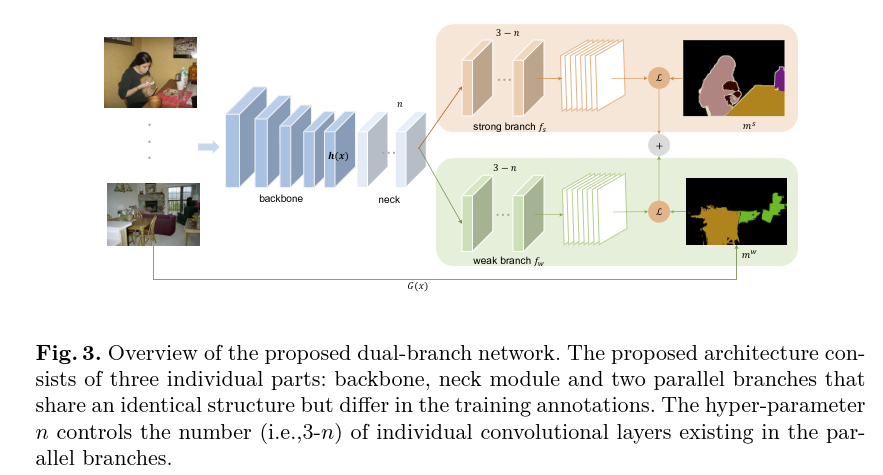

图三是整个方法的总览。将整个训练集分为 和 两部分,分别代表强标签和弱标签集。弱标签集的监督信号由代理监督生成器 生成: ,代理监督生成器需要一些额外的信息,例如该图像的类别标签。

3.1 过采样对单分支网络没有帮助

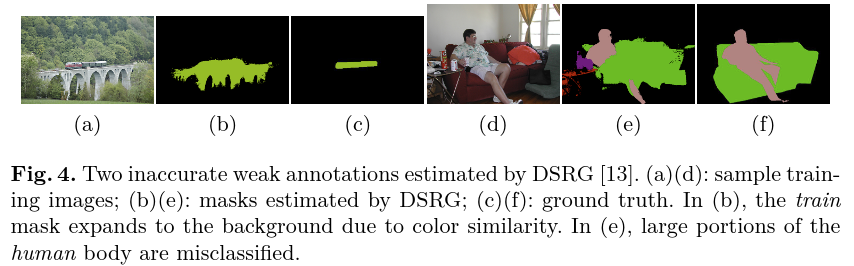

以前的方法侧重于生成更精确的监督信号,但他们并未关注如何协调强弱标签。当图像场景复杂时会有相当多低质量的图像标注(如图四),如果对强弱标签做相近的处理会导致回传的梯度偏向不正确的弱标签,因此会导致新能下降。作者尝试了对强标签做过采样,这一操作是有帮助的但是仍然比不过只使用强标签的性能。总的来讲,过采样对于单分支网络并没有帮助。

3.2 强-弱双分支网络

网络架构由三部分组成:backbone、neck、两个并行的相同架构的分支。实验部分主要基于 VGG16 网络。Backbone 网络就是去掉全连接层的分类网络。Neck 模块就是一系列额外的卷积层能够提升特定任务上的性能,其可被后续的并行分支共享。强弱分支有相同的网络架构,其区别是训练监督信号不同,强分支的监督信号是强标签,弱分支的监督信号是弱标签。这种处理不同监督信号的方式比较新颖的,因为现存的半监督语义分割方法基本都是单分支的网络,多分支网络也并没有做不同监督信号的处理,两个分支有独立的参数 和 ,损失函数是交叉熵损失,两个分支的损失权重相同:

3.3 为什么双分支网络有帮助

在训练过程中,我们需要将使用同等多的强标签样本和弱标签样本,在半监督语义分割任务中,这里往往存在大量的弱监督样本,所以在弱监督数据迭代完之前强监督样本已经重复了很多次,实际上是对强监督样本过采样。这种方式能够减轻样本不平衡的影响

双分支网络避免了不同监督信息的互相干扰,可以较好地消除监督不一致的现象。额外的弱监督样本提供了对象的大概位置,从而在一定程度上将正则化引入了 Backbone 中,提升了网络的泛化能力。

3.4 实施细节

当网络训练完成后,弱分支就不再被需要了,因为弱监督样本的信息已经被编码到 Backbone 以及 Neck 模块中了,所以在推理阶段只需要强监督分支的结果即可

# 论文的背景

想利用双分支网络,给予不同的监督信号,弱监督样本起到的其实是正则化的作用,而过采样强监督样本是有帮助的。

# 总结

# 论文的贡献

论文主要的贡献是着眼于改进半监督语义分割的 Image-level 样本的利用方式,作者使用共享 Backbone 和 Neck的双分支网络,分为 Strong 分支以及 Weak 分支,将强监督样本送入 Strong 分支,将弱监督样本送入 Weak 分支,可以较好的消除监督不一致的现象,有助于缓解强弱样本不平衡问题。训练完成后,弱分支就不再需要了,其在训练过程中起到正则化的作用,加强了 Backbone 以及 Neck 网络的泛化能力。

# 论文的不足

# 论文如何讲故事

# 参考资料

https://www.ecva.net/papers/eccv_2020/papers_ECCV/papers/123500766.pdf

- 02

- README 美化05-20

- 03

- 常见 Tricks 代码片段05-12