Awesome-weakly-supervised-semantic-segmentation

Awesome-weakly-supervised-semantic-segmentation

Tricks

CAN:借助先验分布提升分类性能的简单后处理技巧:https://kexue.fm/archives/8728

- 用先验分布来校正低置信度的预测结果,使得新的预测结果的分布更接近先验分布。

数据增强:图像分类训练技巧之数据增强篇:https://zhuanlan.zhihu.com/p/430563265

知识蒸馏

GCN

图像分割

端侧网络

- 反向 Dropout!韩松团队最新工作NetAug:https://mp.weixin.qq.com/s/tBEpRZ3mAQpEmc27g2HuEA

- 现有的正则技术(比如数据增强、dropout)在大网络方面(比如ResNet50)方面通过添加噪声使其避免过拟合取得了极大成功。然而,我们发现:这些正则技术会损害TinyNN的性能(见下图)。 我们认为:不同于大网络通过增广数据提升性能,TinyNN应当通过增广模型提升性能 。这是因为:受限于模型大小,TinyNN往往存在欠拟合现象而非过拟合 。

工业界实践

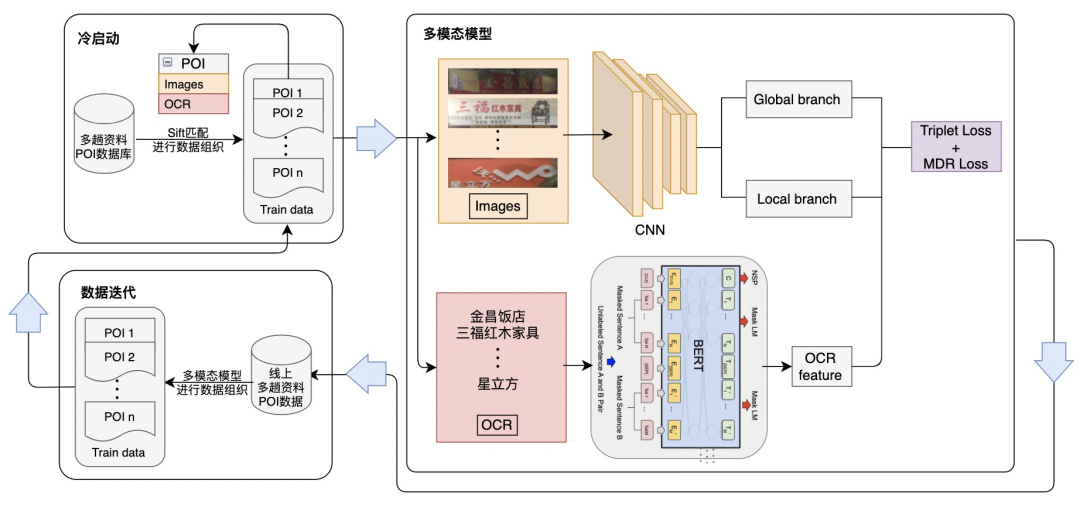

- 图像检索在高德地图POI数据生产中的应用:https://www.modb.pro/db/156377

- 多模态图像检索

学术

- 在做算法工程师的道路上,你掌握了什么概念或技术使你感觉自我提升突飞猛进?:https://www.zhihu.com/question/436874654

上次更新: 2023/03/25, 19:58:09

- 02

- README 美化05-20

- 03

- 常见 Tricks 代码片段05-12